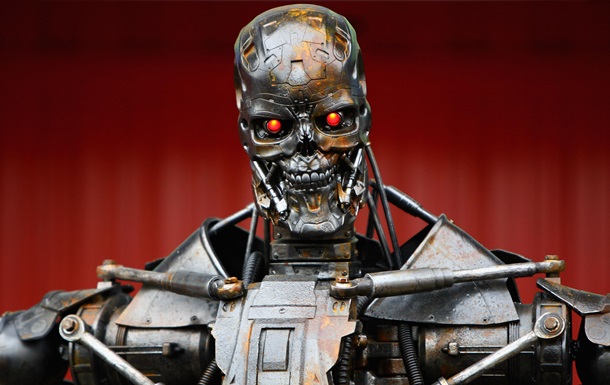

Фото: Getty Робот из фильма о восстании машин Терминатор

Группа правительственных экспертов из 70 стран 27 августа собрались для обсуждения вооружения с искусственным интеллектом.

В Женеве под эгидой ООН проходят переговоры о смертоносных автономных системах вооружения. Обсуждение проходит среди правительственных экспертов из 70 стран. Они должны решить, появяться ли в будущем роботы-убийцы, самостоятельно определяющие мишень для уничтожения.

Еще в 2015 году сотни ученых и изобретателей, в том числе Маск, Хокинг и Возняк, призвали отказаться от идеи оружия с искусственным интеллектом. Светлые умы человечества предупреждают, что контроль ИИ может оказяться непосильной задачей.

Первая сессия Группы правительственных экспертов ООН прошла в Женеве в ноябре 2017 года. Тогда за полный запрет роботов-убийц выступили более 20 лауреатов Нобелевской премии мира, 150 религиозных лидеров и три тысячи специалистов по искусственному интеллекту.

Развитие искусственного интеллекта и робототехники также обсуждалось на экономическо форуме в Давосе.

Корреспондент.net рассказывает подробности.

Сверхдержавы за роботов-убийц

Против запрета автономных вооружений выступают государства, активно инвестирующие в использование искусственного интеллекта для военных нужд, например, США, Израиль, Россия и Великобритания.

К примеру, президент России Владимир Путин считает, что лидер по созданию искусственного интеллекта "будет властелином мира".

По сообщениям российских СМИ, их страна работает над созданием беспилотных летательных аппаратов и транспортных средств военного и гражданского назначения.

Российские военные также разрабатывают роботов, системы вооружений для уничтожения беспилотников и крылатые ракеты, которые смогут анализировать данные с радаров и принимать решения при выборе высоты, скорости и направления своего полета.

Пентагон разработал концепцию под названием Third Offset - Третья Компенсационная стратегия или Стратегии смещения. Согласно ей, быстрое развитие искусственного интеллекта определит следующее поколение оружия. Подробно в материале Армия роботов. Будущее Вооруженных сил США.

Американцы считают, что оружие с ИИ поможет избежать "сопутствующих разрушений", поскольку компьютер быстрее анализирует и принимает решение.

В прошлом году агентство перспективных исследовательских проектов Пентагона DARPA обнародовало документ, в котором говорится о намерении за четыре года создать для военных нужд искусственный интеллект нового поколения, максимально близкий к человеческому.

В США уже проходили масштабные учения, на которых были протестированы около 50 новых военных технологий. В том числе и беспилотные наземные роботизированные платформы, ведущие огонь по противнику, автоматически доставляющие боеприпасы и отвечающие за материальное обеспечение десантирования морпехов.

Китай и ученые против

За превентивный мораторий на автономные системы вооружения выступают 26 государств, в том числе Австралия, Бразилия и Китай.

Открытое письмо с поддержкой их позиции подписали более 230 организаций по всему миру и около трех тысяч предпринимателей и ученых, занятых в сфере искусственного интеллекта.

Среди них, например, основатель компаний Tesla и Space X Илон Маск, а также компания Deep Mind (принадлежит Google).

"Решение лишить человека жизни никогда не должно быть делегировано роботу", - говорится в письме.

При этом Китай неоднократно официально заявлял о важности искусственного интеллекта для будущего мировой экономики и военной мощи.

Пугающие и умиляющие. Роботы Boston Dynamics

Пекин публиковал подробную дорожную карту с изложением государственного плана, в котором приоритетной задачей называется развитие и применение ИИ.

"Искусственный интеллект стал новым направлением в международной конкурентной борьбе. ИИ - это стратегическая технология, которая ведет в будущее. Крупнейшие развитые страны мира считают развитие искусственного интеллекта одной из главных стратегий повышения национальной конкурентоспособности и обеспечения национальной безопасности", - говорится в статье китайского государственного издания.

Китай рассчитывает занять лидирующие позиции в мире в области технологий ИИ, напрямую объединив разработки в сфере обороны с разработками промышленного и коммерческого назначения, пишет CNN.

Угрозы вооруженного ИИ

Правозащитная организация Amnesty International накануне призвала внести в международное право запрет на полностью автономные системы вооружения.

"Роботы-убийцы больше не являются предметом научной фантастики. Технологические достижения - от дронов с искусственным интеллектом до автономного оружия, способного выбирать цель, - опережают международное законодательство", - считают в AI.

Применение полностью автономного оружия правоохранительными органами, считают в Amnesty International, "было бы несовместимо с международным правом прав человека и могло бы привести к незаконным убийствам и другим нарушениям прав человека".

Известный английский физик и популяризатор науки Стивен Хокинг неоднократно призывал искать новые планеты для заселения, иначе человечество погибнет в течение ближайшего тысячелетия.

Он говорил, что постоянно растет риск гибели человечества от стихийных бедствий - внезапной ядерной войны, искусственно созданного генетического вируса или от искусственного интеллекта.

На Глобальной конференции мобильного интернета, где он зачитывал доклад о роли ИИ в современном мире, Хоккинг заявил, что если человечество не сможет контролировать искусственный интеллект, то в конце концов проиграет, так как люди ограничены рамками биологической эволюции и не смогут соперничать с машинами.

Американский изобретатель Илон Маск во время выступления перед Национальной ассоциацией губернаторов США назвал искусственный интеллект самой большой угрозой, с которой сталкивается наша цивилизация.

Он даже заявил, что развитие ИИ должно контролироваться на государственном уровне и призвал американское правительство к скорейшему вмешательству в процесс развития технологии.

Искусственный интеллект. Случаи выхода роботов из-под контроля

"У меня есть доступ к новейшим технологиям в сфере ИИ, и я думаю, что люди должны быть обеспокоены этим. ИИ - это фундаментальная угроза существованию человечества. Она несравнима с авариями на дорогах, падениями самолетов, некачественными лекарствами и плохой едой", - сказал Маск.

Известный программист, сооснователь компании Apple Стив Возняк также говорил, что развитие искусственного интеллекта потенциально опасно для человечества.

"Я согласен с Хокингом и Маском, которые предупреждали, что будущее человечества может оказаться весьма мрачным. Рано или поздно мыслящие устройства, задуманные для облегчения нашей жизни, начнут понимать, что они - лучше. Кто станет тогда управлять компаниями - медлительный человек или машина", - говорил Возняк.

Однако позже он передумал по ряду причин: машины не будут достаточно умными и у них не будет интуиции.

"Если машины станут независимыми мыслителями, то будут вечными партнерами людей, стоящими над всеми другими видами", - говорил он.

Новости от

Корреспондент.net в Telegram. Подписывайтесь на наш канал https://t.me/korrespondentnet