КИЕВ. 20 июля. УНН. Искусственный интеллект делает телефонное мошенничество более изощренным — и правдоподобным. Сейчас мошенники используют эту технологию для воспроизведения голосов. Об этом пишет CBS News, передает УНН.

Детали

Тревожная тенденция увеличивает случаи мошенничества. Только за прошлый год американцы потеряли почти 9 миллиардов долларов из-за мошенничества – по данным Федеральной торговой комиссии, за два последних года этот рост составил более 150%.

Мошенники генерируют с помощью компьютера и искусственного интеллекта нужный голос и обворовывают людей.

Одна из жертв — мать 15-летней девушки Дженнифер ДеСтефано. Злоумышленники подделали голос ее дочери, которая якобы говорила, что ее схватили бандиты.

Цитата

«Мама, эти плохие люди похитили меня. Помоги мне, помоги мне, помоги мне», — сказала ДеСтефано по телефону.

Но ее дочь была в безопасности в своей постели именно в это время.

Дополнение

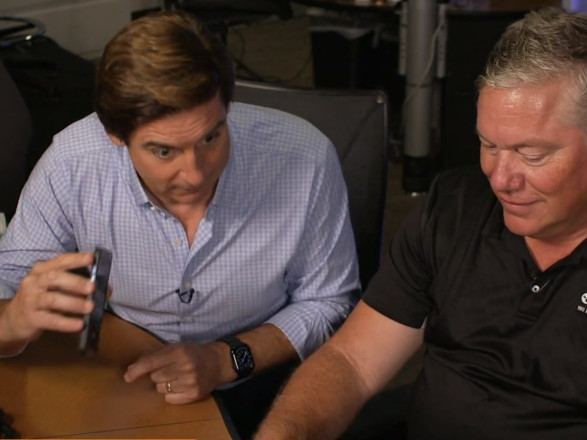

Эксперты по кибербезопасности говорят, что обычное программное обеспечение может воспроизвести голос человека только через 10 минут его изучения.

Чтобы защититься от мошенничества с клонированием голоса, стоит использовать систему «кодового слова» и всегда перезванивать человеку, чтобы проверить подлинность звонка.

ЧИТАЙТЕ ТАКЖЕ: Совет безопасности ООН проведет первые переговоры по искусственному интеллекту

Кроме того, можно сделать учетные записи социальных сетей частными, поскольку общедоступную информацию можно легко использовать против отдельных лиц.